摘要:微光环境下CMOS相机拍摄的图像存在对比度低、噪声大和细节模糊等问题,目前的增强算法虽然可以提升图像亮度,却没有考虑保留原始图像的细节信息,为此,本文提出了一种细节保留的微光

微光环境下CMOS相机拍摄的图像存在对比度低、噪声大和细节模糊等问题,目前的增强算法虽然可以提升图像亮度,却没有考虑保留原始图像的细节信息,为此,本文提出了一种细节保留的微光图像增强方法。首先,使用自适应滤波器对原始微光图像中的每个通道进行处理,以改善噪声对图像的影响。然后,通过滤波后的图像得到细节层和基本层,其中细节层用于保留图像的纹理,基本层则用于增强图像的亮度。细节层的求取通过粗照度和光照分量得到,而基本层亮度增强则使用Alpha算法融合原图、伽马校正结果和伽马先验校正结果得到。最后,将细节层和基本层的亮度通道进行融合,以获得增强后的图像。实验结果表明,经过细节融合处理后的图像,其平均梯度与信息熵均实现了显著提升。此外,与选取的5种方法相比,SSIM指标均高于其他算法,表明本文方法增强后的图像失真小。同时,在BRISQUE和PSNR指标上均取得了较好的效果。

关键词

噪声抑制;细节求取;图像融合;微光图像

论文《细节保留与亮度融合的微光图像增强算法》发表在《红外技术》,版权归《红外技术》所有。本文来自网络平台,仅供参考。

0 引言

随着电子技术的迅速发展,CMOS相机由于其低成本、高成品率和低制作难度等优势,使成像设备应用范围不断扩大,这也使得图像数据呈现爆炸式的增长趋势。然而,在实际应用中,成像条件并不总是理想的。在医疗领域中,内窥镜容易受到光源干扰和人体组织复杂性影响,导致图像对比度低、光照不均匀、细节模糊[1];在安防监控领域,夜晚自然光照强度大幅降低,使监控相机所得到的图像细节难以辨认[2];在交通驾驶领域,车牌常常遭受光照、天气和拍摄位置等因素的干扰,导致车牌图像信息模糊不清[3-4]。因此,在微光图像亮度提升的同时保留图像细节信息就显得尤为重要。

目前,针对微光图像增强问题,主要分为传统方法和基于深度学习的神经网络方法。

传统方法有灰度变换方法、基于直方图均衡化方法、Retinex方法和频域处理方法。灰度变换方法[5]通过调整像素的灰度值分布和动态范围来增强图像。基于直方图均衡化方法[6]通过调整图像的灰度级分布来提高图像的对比度和亮度。Retinex方法[7]将图像分解为照射分量和反射分量,通过增强照射图以提高图像的亮度。频域处理方法[5]先将图像转换到频率域进行处理,再逆向转换回空间域。然而,这些方法或者只关注提高图像亮度,忽视了对原始细节信息的提取,或者对图像细节的恢复效果不尽人意。

基于深度学习的神经网络方法有RetinexNet、LLCNN、EGAN等。RetinexNet通过估计光照图以调整光照分量来增强微光图像[8]。LLCNN通过卷积神经网络学习微光图像的特征,并改进局部对比度来进行微光图像的增强[9]。EGAN通过生成对抗网络和自监督机制以实现对微光图像的增强[10]。尽管神经网络相对传统方法在亮度提升和细节恢复方面具有优势,但目前的处理方法仍然更加注重图像亮度和对比度的提高,并没有引入专门的细节保留模块。

针对上述问题,本文提出了一种细节保留的微光图像增强方法,该方法在经过滤波之后求取原图像的基本层与细节层,基本层用于提高原图像的亮度,细节层用于保留原图像纹理细节,最后将两个图层进行融合得到增强的图像。

1 细节保留与亮度融合算法

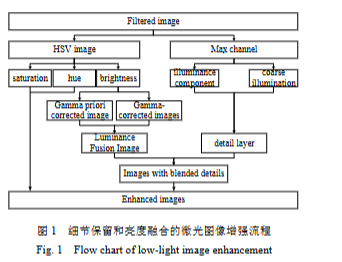

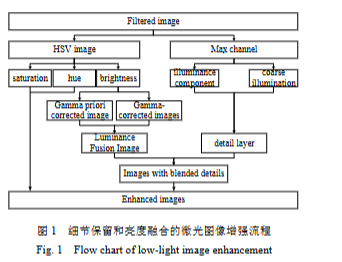

该算法的框架流程如图1所示。为了防止噪声对微光图像增强的影响,输入的低照度图像的R、G、B三个通道都采用自适应空间滤波。将经过滤波处理后的图像分为两步处理,第一步根据粗照度和使用双边滤波估计的光照分量计算原始图像的细节;第二步将图像从RGB颜色空间转换到HSV颜色空间,并使用第一步得到的光照分量代替V通道,同时使用改进的对数变换作为幂值对光照分量使用伽马校正和伽马先验校正,然后通过Alpha融合算法将二者与光照分量融合为一个新的亮度通道。将细节融合进新的亮度通道后再将图像从HSV颜色空间转换到RGB颜色空间。

1.1 自适应滤波

对于RGB图像中的每个原始通道,使用分步滤波方法进行处理。先对相关噪声进行过滤,再对不相关噪声进行滤除。由于相邻信号之间存在相关性,图像传感器的读出电路会对相邻信号进行干扰,从而引入条纹噪声和色斑噪声即相关噪声。不相关噪声通常表现为随机噪声和均匀噪点,其来源主要是暗电流和量化噪声[11]。两种噪声的抑制采用公式(1):

[x'(i, j)=frac{sigma × x(i, j)+overline{x}^{2}}{sigma+overline{x}+varepsilon} p(i, j)=n(i, j) × x'(i, j)+(1-n(i, j)) × x(i, j)]

式中:(x'(i, j))为相关噪声抑制结果;(p(i, j))为不相关噪声抑制结果即最终滤波结果;(x(i, j))、(�ar{x})和σ分别表示为窗口W的像素值、均值和方差;ε为一个极小值;(n(i, j))为二值噪声矩阵,用于指明窗口W中的不相关噪声的位置,通过比较窗口W中每个像素与窗口的误差中值获得。

滤波前后结果如图2所示,图(a)为无滤波增强图像,图(b)为滤波后的增强图像。无滤波时,红圈中的暗区增强后会出现密集的黑点,经过滤波后黑点基本消失,且图像变得光滑。

1.2 细节提取

本文的细节提取算法是受到Retinex算法启发而来。Retinex算法是一种常用的图像增强算法,在算法中通常需要估计图像的光照分量,而光照分量包含了图像的边缘和细节信息。为了从光照分量中提取出图像的细节信息,需要在最大通道上估计出粗光照和光照分量。最大通道即R、G、B通道的最大值,由公式(2)确定:

[L(i, j)=max _{c in(R, G, B)} I^{c}(i, j)]

式中:(L(i, j))为原始图像在点((i, j))处的3个通道最大值,(I^{C}(i, j))为原始图像。假设局部图像块中的光照是恒定的,粗光照则是最大通道的扩展即一个图像块中的最大光照强度应该具有近似相同的照度值。为了克服在光照边缘处由于光照不恒定而带来的块效应,使用公式(3)在估计粗光照的同时保持边缘[12]:

[L^{e}(i, j)=frac{sum_{(i, j) in W} eta(i, j) × g(i, j) × L^{i}(i, j)}{sum_{(i, j) in W} eta(i, j) × g(i, j)}]

式中:(L^{ heta}(i, j))为保持边缘的粗光照;(L^{i}(i, j))为粗光照;(eta(i, j))为阶跃函数;(g(i, j))为类值域核函数。相比最大通道,粗光照更加接近真实照明结果。(L^{i}(i, j))、(eta(i, j))和(g(i, j))由公式(4)分别计算:

[�egin{aligned} & L^{i}(i, j)=max _{c in(R, G, B)}left(max _{(i, j) in W} I^{c}(i, j)

ight) \ & eta(i, j)=left{�egin{array}{cc} 1 & L^{i}(i, j)-L(i, j) geq 0 \ 0 & L^{i}(i, j)-L(i, j)<0 end{array}

ight. \ & g(i, j)=e^{-frac{left|L^{i}(i, j)-2 × L(i, j)

ight|}{2 sigma^{2}}} end{aligned}]

光照分量的估计采用双边滤波器来实现,它能在平滑纹理的同时保持边缘信息。双边滤波器估计的光照分量由公式(5)确定:

[�egin{aligned} & L^{b}(i, j)=frac{1}{W} sum W_{s} × W_{r} × I(i, j) \ & W_{s}=exp left(-frac{(i-k)^{2}+(j-l)^{2}}{2 sigma_{s}^{2}}

ight) \ & W_{r}=exp left(-frac{(I(i, j)-I(k, l))^{2}}{2 sigma_{r}^{2}}

ight) \ & W=sum W_{s} × W_{r} end{aligned}]

[W=sum W_{s} × W_{r}]

式中:(L^{b}(i, j))为估计的光照分量;W为权重;(W_{s})为空间域核函数;(W_{r})为值域核函数;((i, j))为窗口Ω中的某像素坐标;(I(i, j))为对应的像素;((k, l))为窗口Ω中值的坐标,(I(k, l))为中值。

图3是提取出的粗光照与光照分量,它们与原图的灰度图相比,整体亮度稍亮。

由估计的光照分量和粗光照得到的粗细节层如公式(6):

[D_{int }(i, j)=frac{L^{b}(i, j)}{L^{e}(i, j)+varepsilon}]

式中:(D_{int }(i, j))为提取的细节;ε是一个极小值。粗细节层包含了一些冗余细节和噪声还不能用于后续细节融合,本文在此基础上加入了调制因子d以减少上述缺点。

[d=frac{D_{std }}{D_{men }} quad(7)]

式中:(D_{std })和(D_{men })是粗细节层的方差和均值。

如图4所示,加入调制因子d前后的细节层为图(a)和图(c),分别与增强的亮度通道融合后的图像为图(b)和图(d)。从图(b)和图(d)可以看出加入调制因子d后图中物体边缘更加平滑,黑边消失。

对细节层进行模糊处理,从而减弱这种现象,或者去马赛克算法消除。在实际应用中,需要根据具体情况选择合适的核大小来进行高斯滤波处理,并且也可以针对性地调整去马赛克算法的参数以达到更好的效果。在背景虚化的微光图像上使用本文细节层算法进行图像增强可能会导致增强后的图像出现马赛克现象。为了解决这个问题,可以选择使用高斯滤波算法。

1.3 亮度增强

本文将对经过滤波处理的RGB图像进行HSV颜色空间转换,并使用双边滤波估算出的光照分量来替代原始V通道以实现图像亮度增强。先使用自适应伽马校正和伽马先验校正对光照分量进行预处理,再将二者校正后的图像与光照分量通过Alpha算法进行融合。

原本的伽马校正先验公式的作用是图像去噪和去雾,根据文献[13],本文使用伽马先验校正增强微光图像的亮通道。自适应伽马校正和伽马先验校正公式定义如下:

[L^{gc}(i, j)=L^{b}(i, j)^{s(i, j)} L^{gcp}(i, j)=1-left(1-L^{b}(i, j)

ight)^{frac{1}{s(i, j)}}]

式中:(L^{gc}(i, j))为伽马校正结果;(L^{gcp}(i, j))为伽马先验校正结果;(L^{b}(i, j))为归一化的值;(s(i, j))为改进后的对数变换,这里作为校正公式的幂。经过对数变换后,图像的亮度值会发生反转即暗处的像素值将会变得更大,而亮处的像素值则会变得更小,再将对数变换的结果作为伽马校正和伽马先验校正的幂,可以使淹没在黑暗中的细节暴露出来。本文对数变换公式如下:

[s(i, j)=left{�egin{array}{l}frac{log left(men+L^{b}(i, j)

ight)}{log left(std^{c}

ight)}+std & med > std \ frac{log left(men+L^{b}(i, j)

ight)}{log left(std^{c}

ight)}+med & med leq std end{array}

ight.]

式中:(s(i, j))为对数变换结果;men、med和std分别为光照分量的均值、中值和方差;c为幂值,用以控制对数变换后图像数值的大小即反转后图像的亮度。不同图像的c值可按下式取值:

[c=left{�egin{array}{ll} frac{ med }{ immse × men } & med > immse \ frac{ men }{ immse × med } & 0.025 med \ frac{ med + immse }{ std +med } & med leq 0.025, std < med end{array}

ight.]

式中:immse为光照分量的均方误差。

Alpha融合算法是在原本的图像通道外重新定义了第四通道即Alpha通道,该通道反映了图像的透明度信息。在将前景图像叠加到背景图像的过程中,改变Alpha通道的值可使新图像既包含前景图像又包含背景图像[14]。本文通过修改原先两图像的Alpha融合算法得到了适用于三图像的Alpha融合算法,公式如下:

[V=frac{m_{b} × L^{b}+m_{gc} × L^{gc}+m_{g} × L^{gc}+m_{g} × L^{gcp}}{m_{b}+m_{gc}+m_{gcp}} (11)]

式中:V为融合后的亮度通道;(m_{b})、(m_{gc})、(m_{gcp})分别为光照分量、伽马校正和伽马先验校正归一化后的均值,以此来代表各自图像的透明度。

亮度通道增强过程如图5所示,原图(a)经过图(b)的对数曲线处理后,其图像亮度反转为图(c)。以图(c)的值作为幂值,在经过伽马校正和伽马先验校正后得到图(d)和(e)。相比于原图,这两幅图像的亮度得到了明显提高,其中图(d)的亮度提高的更多。图(a)、(d)和(e)被融合成图(f),其亮度在(d)和(e)之间。该融合方式可以防止单独使用图(d)时带来的过曝光情况,同时也能够防止单独使用图(e)时亮度增强不足的情况。

1.4 细节融合

在上一节中,使用Alpha融合算法来提高图像的亮度,但图像细节并不能很好地保留,反而会导致增强后的图像变得模糊、纹理不清晰。因此,为了在提高图像亮度的同时保留其细节,本文将细节层与增强后的亮度通道进行融合。如图6所示,经过融合后的图像在提高亮度的同时细节也得到了很好的保留。融合公式如下:

[V^{d}=V × D quad(12)]

式中:(V^{d})为融合细节层的亮度通道;V为增强后的亮度通道;D为加入调制因子的细节层。

2 实验结果与分析

2.1 细节保留实验

为了评估本文算法在保留图像细节方面的能力,对LOL数据集[15]中的图像进行了处理。首先,获取了经过亮度增强但没有融合细节的图像,以及融合了细节的亮度增强图像。然后,分别计算了这两种图像的平均梯度(AG)[16]以及完全增强图像的信息熵(Entropy)[15]。AG和Entropy指标可以反映图像的细节程度,数值越大表示图像中细节越丰富。因此,通过计算AG和Entropy指标,可以量化算法对图像细节的保留能力。

图7展示了LOL数据集中部分图像的AG和Entropy指标计算结果,而表1则展示了这些图像中AG和Entropy的提升百分比。对于其他图像,其计算结果与图中所示相一致。从图7可以明显观察到以下情况:融合了细节的亮度增强图像的AG值普遍高于没有融合细节的亮度增强图像,同时融合了细节的完全增强图像的Entropy值普遍高于原始图像。通过表1可以看出,融合了细节的图像的AG和Entropy值均有显著的提升。这两个指标的变化表明,融合了细节的增强图像具备更为丰富的信息内容和更加充分的细节展现。

2.2 微光图像增强实验

为了评估本文算法对整体微光图像处理的效果,对不同类型的图像使用对比度受限的自适应直方图均衡化算法(contrast limited adaptive histogram equalization, CLAHE)[17]、带色彩恢复的多尺度视网膜增强算法(multi-scale Retinex with color restoration MSRCR)[18]、基于照度估算的方法(low-light image enhancement, LIME)[19]、用于增强低光照视频的快速高效算法(Dong)[20]、微光图像增强的仿生多重曝光融合算法(bio-inspired multi-exposure fusion, BIMEF)[21]进行处理,并使用主流的图像评价指标进行评价。

2.2.1 无参考图实验

本文使用ExDark数据集[22-23]进行无参考图实验。该数据集包含了7千多张自然环境中的微光图像。实验中使用上述算法对该数据集中的图像进行处理,图8所示的是不同类型的微光图像的部分处理结果。

经过CLAHE处理后的图像整体亮度增强不足,一些细节还隐藏在黑暗中。经过MSRCR处理的图像,图像亮度不恒定,会出现某些图像亮度足够,某些图像亮度不足的情况。经过LIME处理后的图像亮度过曝,导致暗区过增强呈现黑块。经过Dong处理的图像,边缘黑边严重。经过BIMEF处理的图像亮度提升明显。本文算法处理后的图像,亮度适中,无黑边现象。

为了进一步评价本文算法对无参考图的处理效果,使用BRISQUE[24]、Entropy和NRSS[15,25]三个指标进行评价。BRISQUE反应了图像的失真程度或图像的视觉质量;Entropy反应了图像的信息丰富度即图像的边缘、纹理和细节特征;NRSS(no-reference structural sharpness)反应了图像的模糊程度。

从表2可以看出,除Boat图像的BRISQUE值大于MSRCR算法,其他均小于其他算法,表明经过本文处理的图像失真小。因LIME算法处理后的图像过曝,暴露出了更多的细节,故Entropy值小于LIME算法,但与BIMEF和Dong相近甚至部分图像的Entropy值超过,且大于CLAHE和MSRCR算法,表明本文算法可以较好的保留图像的边缘细节。NRSS值除Bus图像小于LIME算法,其他均高于其他算法,表明经过本文处理的图像具有很好的清晰度。

2.2.2 有参考图实验

本文使用BrighteningTrain数据集[26]进行有参考图实验。该数据集包含了1000张真实场景拍摄的微光图像和对应的正常亮度图像。实验中使用上述算法对该数据集中的图像进行处理,并选取不同类型的微光图像的部分处理结果进行展示,结果如图9所示。

经CLAHE处理后的图像亮度太暗,存在少量偏色问题;经MSRCR处理的图像亮度一致性差,不同类型图像之间亮度存在过亮和较暗情况,同一张图像也会存在过曝和过暗情况;经LIME处理后的图像亮度过度曝光导致整体泛白,且色彩饱和度过高,纹理过于平滑;经Dong处理后的图像虽然提高了亮度,但图像边缘黑边明显,人眼视觉感受差;经BIMEF处理的图像亮度有所提高,但还低于正常图像;本文算法处理的图像亮度最接近原图,一致性好,且保留了部分细节。

鉴于BRISQUE、Entropy以及NRSS评价指标无法利用参考图像进行图像质量评估,为了更全面地评价本文所提算法的性能表现,采用能够利用参考图像的评价指标,即结构相似性(structural similarity, SSIM)和峰值信噪比(peak signal-to-noise ratio, PSNR)[27],作为衡量标准,对上述不同算法处理后的图像质量进行评估。PSNR用于度量微光图像经过处理后的噪声水平;而SSIM用于衡量图像的相似程度,该指标可反应不同算法处理后的图像品质。

从表3可看出,本文算法的SSIM指标均高于其他算法,表明经过本文算法处理的图像更加接近原始正常亮度图像;PSNR指标高于CLAHE、MSRCR、LIME算法,但对于Scenery图像低于Dong和BIMEF算法,对于Person图像低于BIMEF算法,表明本文算法可以有效抑制微光图像增强后的噪声。

2.3 算法运行时间

为了测试不同算法的处理速度,本文从无参考图和有参考图的数据集里选择不同分辨率的微光图像进行实验,实验结果如表4所示。CLAHE方法因图像分块均衡化、每小块内部操作简单故运行时间最短,且运行时间对图像大小的增加表现出极高的鲁棒性,即便图像尺寸显著扩大,其运行时间的增幅亦相当有限;与CLAHE方类似,BIMEF方法在局部区域进行曝光融合操作且有选择性地对微光区域进行处理,故运行时间快;MSRCR方法由于其多尺度高斯滤波操作而具有较高计算复杂度;Dong算法将微光图像增强问题转化成了暗通道去雾问题,又因低光照图像的反转图,可以看成是雾很严重的情况,在使用暗通道去雾算法求取反转图时需要更多的计算时间;LIME方法需要迭代优化来估计图像的光照图从而增加了算法的计算复杂度和运行时间,导致运行时间最长;本文算法因含有滤波等操作导致运行时间低于CLAHE和BIMEF方法,但又不含迭代计算从而使运行时间快于其他方法。

3 结论

为避免微光图像增强过程中出现细节丢失导致图像信息恢复不足,本文提出了一种细节保留与亮度融合的微光图像增强算法。在微光图像亮度增强的同时融合细节层以保留原始图像的纹理信息。实验结果表明,融合了细节层的图像在AG方面可以提升49%,信息熵可以提升43%。无参考图情况下,增强后的图像Entropy值可达7.7911,BRISQUE值可达5.8177,表明本文算法很好地保留了原始图像的细节。有参考图对比时,增强后的图像SSIM值达到0.965。表明增强后的图像与原图之间具有最高的相似度,同时图像失真也最小。

参考文献

[1] WANG L, WU B, WANG X, et al. Endoscopic image luminance enhancement based on the inverse square law for illuminance and retinex[J]. The International Journal of Medical Robotics and Computer Assisted Surgery, 2022, 18(4): e2396.

[2] 朱明秀. 视频图像处理技术在安防行业的应用[J]. 电子技术与软件工程, 2020(2): 155-156.

[3] 曹行健, 张志涛, 孙彦赞, 等. 面向智慧交通的图像处理与边缘计算[J]. 中国图象图形学报, 2022, 27(6): 1743-1767.

[4] 马晓东. 数字图像处理技术在智能交通中的应用[J]. 电脑知识与技术, 2022, 18(21): 123-124.

[5] WANG W, WU X, YUAN X, et al. An experiment-based review of low-light image enhancement methods[J]. IEEE Access, 2020, 8: 87884-87917.

[6] 扈佃海, 吕绪良, 文刘强. 一种改进的直方图均衡化图像增强方法[J]. 光电技术应用, 2012, 27(3): 65-68.

[7] 黄辉先, 陈凡浩. 基于注意力机制和Retinex的低照度图像增强方法[J]. 激光与光电子学进展, 2020, 57(20): 53-60.

[8] 何锦成, 韩永成, 张闻文, 等. 基于通道校正卷积的真彩色微光图像增强[J]. 兵工学报, 2023, 44(6): 1643-1654.

[9] Lore K G, Akintayo A, Sarkar S. LLNet: A deep autoencoder approach to natural low-light image enhancement[J]. Pattern Recognition, 2017, 61: 650-662.

[10] 赵兴运, 孙帮勇. 融合注意力机制和上下文信息的微光图像增强[J]. 中国图象图形学报, 2022, 27(5): 1565-1576.

[11] 刘嵘侃, 邢德智, 唐昭焕, 等. 低噪声CMOS图像传感器技术研究综述[J]. 半导体光电, 2020, 41(6):768-773.

[12] GAO Y, HU H M, LI B, et al. Naturalness preserved nonuniform illumination estimation for image enhancement based on retinex[J]. IEEE Transactions on Multimedia, 2017, 20(2): 335-344.

[13] LI C, TANG S, YAN J, et al. Low-light image enhancement via pair of complementary gamma functions by fusion[J]. IEEE Access, 2020, 8: 169887-169896.

[14] 杨斌. 基于FPGA的头戴显示器视频图像处理系统设计与实现[D]. 成都: 电子科技大学, 2021.

[15] 陈清江, 顾媛, 李金阳. 双分支金字塔网络的微光图像增强算法[J]. 液晶与显示, 2022, 37(3): 395-404.

[16] 杨艳春, 李娇, 王阳萍. 图像融合质量评价方法研究综述[J]. 计算机科学与探索, 2018, 12(7): 1021-1035.

[17] Zuiderveld K. Contrast limited adaptive histogram equalization[J]. Graphics Gems, 1994: 474-485.

[18] Petro A B, Sbert C, Morel J M. Multiscale retinex[J]. Image Processing On Line, 2014: 71-88.

[19] GUO X, LI Y, LING H. LIME: low-light image enhancement via illumination map estimation[J]. IEEE Transactions on Image Processing, 2016, 26(2): 982-993.

[20] DONG X, PANG Y, WEN J. Fast efficient algorithm for enhancement of low lighting video[C]//IEEE International Conference on Multimedia and Expo, 2011.

[21] YING Z, LI G, GAO W. A bio-inspired multi-exposure fusion framework for low-light image enhancement[J]. arXiv preprint arXiv, 1711.00591, 2017.

[22] Loh Y P, Chan C S. Getting to know low-light images with the exclusively dark dataset[J]. Computer Vision and Image Understanding, 2019, 178: 30-42.

[23] JIANG Y, GONG X, LIU D, et al. EnlightenGAN: deep light enhancement without paired supervision[J]. IEEE Transactions on Image Processing, 2021, 30: 2340-2349.

[24] Mittal A, Moorthy A K, Bovik A C. No-reference image quality assessment in the spatial domain[J]. IEEE Transactions on Image Processing, 2012, 21(12): 4695-4708.

[25] 谢小甫, 周进, 吴钦章. 一种针对图像模糊的无参考质量评价指标[J]. 计算机应用, 2010, 30(4): 921-924.

[26] ZHOU D, QIAN Y, MA Y, et al. Low illumination image enhancement based on multi-scale cycle GAN with deep residual shrinkage[J]. Journal of Intelligent & Fuzzy Systems, 2022, 42(3): 2383-2395.

[27] 刘柯, 李旭健. 水下和微光图像的去雾及增强方法[J]. 光学学报, 2020, 40(19): 73-85.